Alternative Metriken ( engl. Altmetrics) gelten als Weiterentwicklung der traditionellen

bibliometrischen Verfahren. Sie berücksichtigen neue Techniken wissenschaftlichen Arbeitens und Quellen des Web 2.0. Die Bezeichnung geht vermutlich auf einen Tweet von Jason Priem (2010) zurück. Gemeinsam mit anderen Autor*innen hat er seine Vorstellungen in einem Manifest niedergeschrieben.

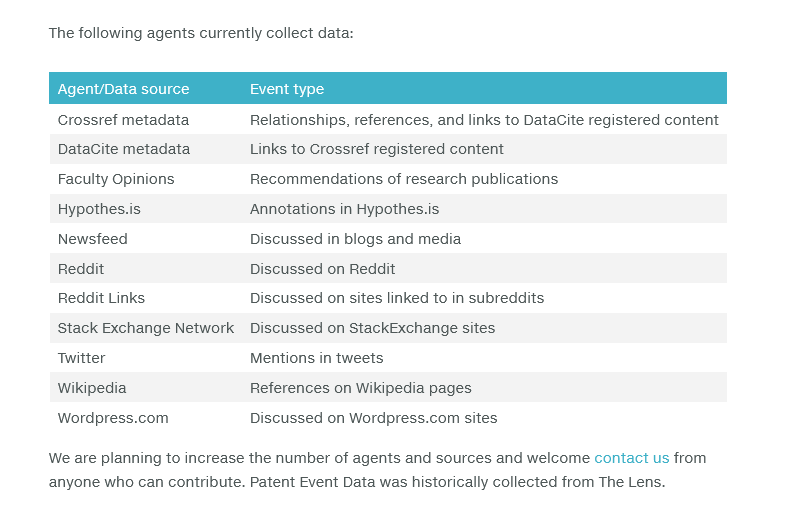

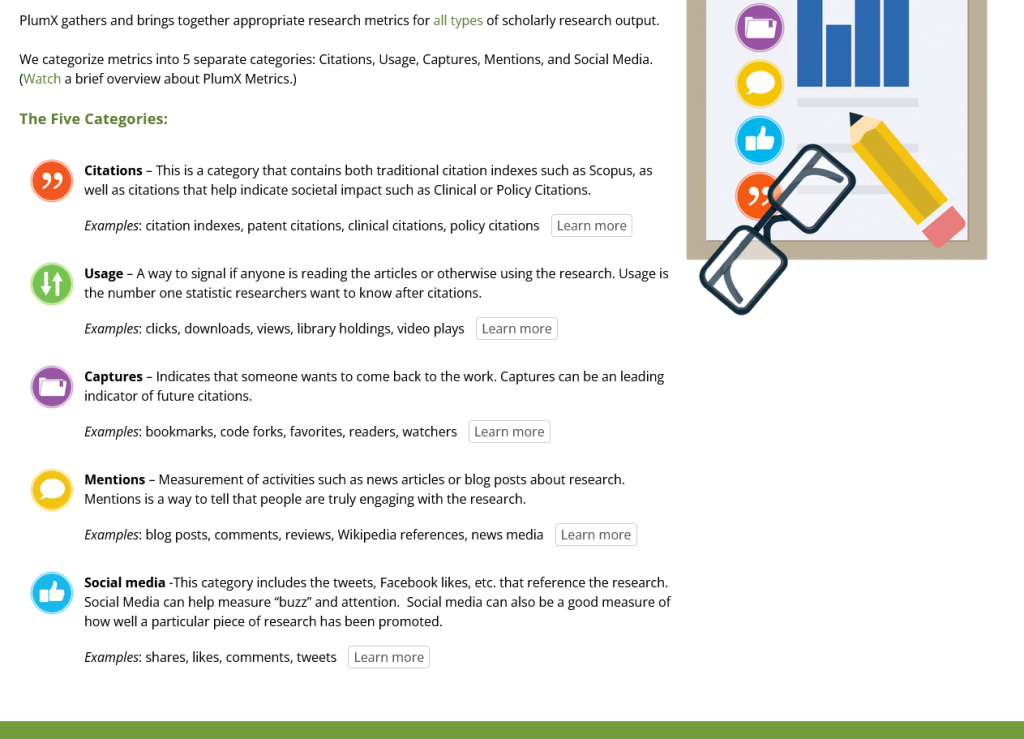

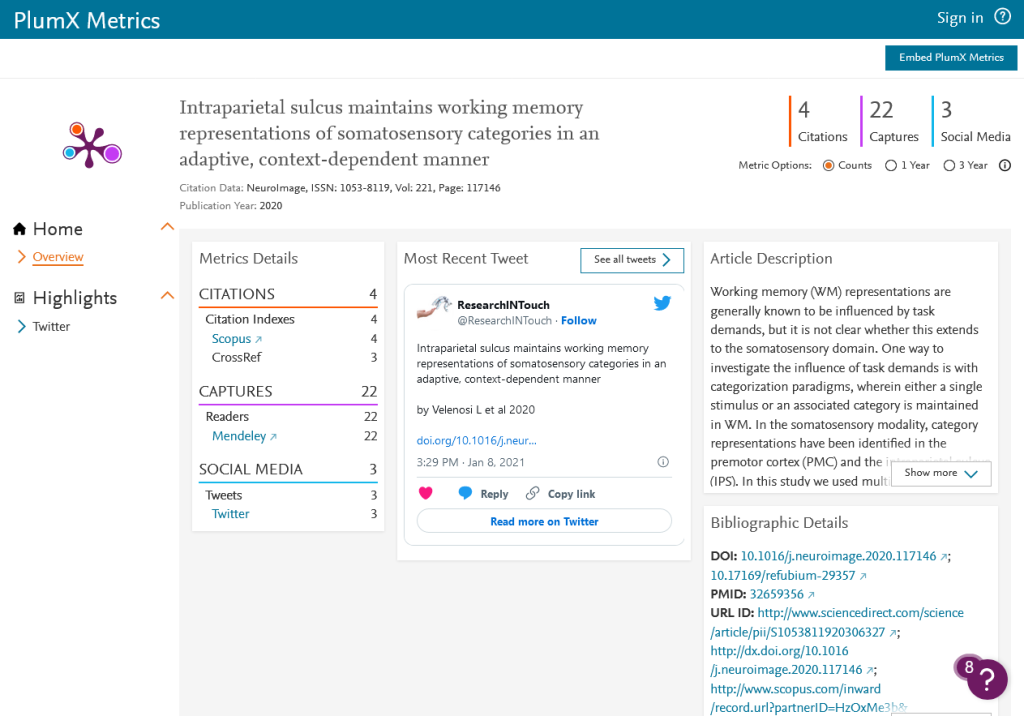

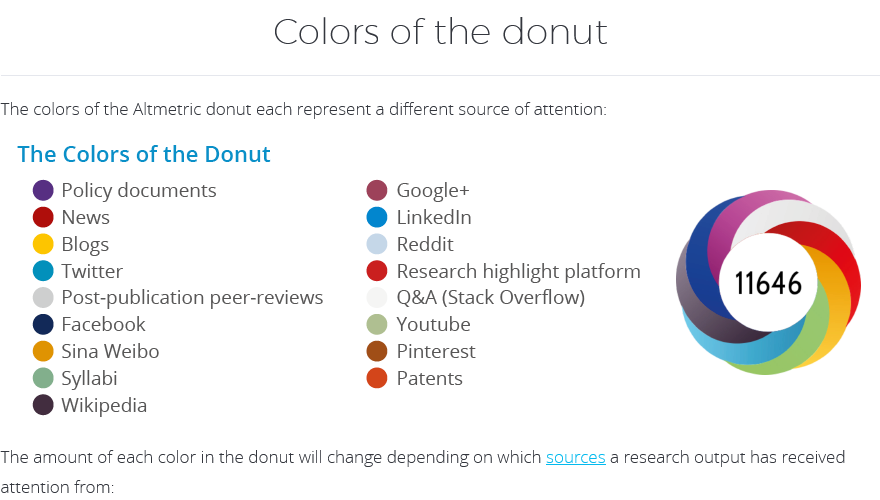

Gemessen werden Aktionen, die Webdokumente

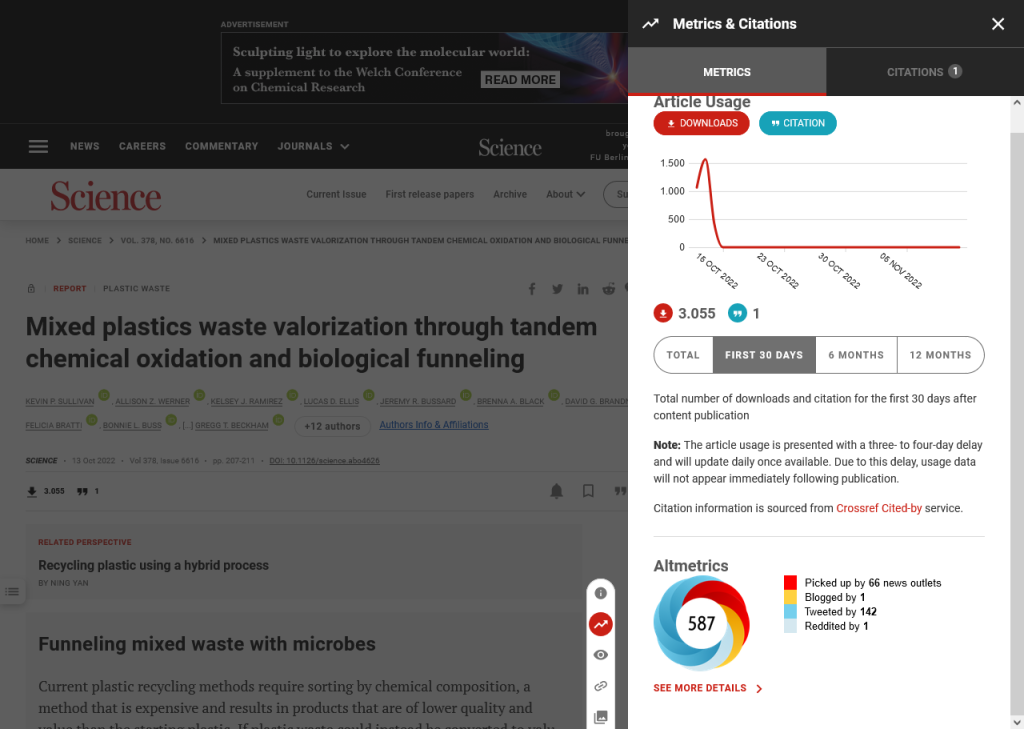

- nutzen (aufrufen und herunterladen)

- besprechen und verlinken, auf Webseiten von wissenschaftlichen

Institutionen oder Nachrichtenportalen - diskutieren und liken z. B. in Blogs, auf Twitter, in anderen sozialen Netzwerken, referenzieren in webbasierten Literaturmanagementsystemen wie Mendeley

Vorteile:

- Altmetriken berücksichtigen die durch das Internet veränderten

Arbeitsweisen und Kommunikationswege. - Die Aufmerksamkeit, die eine Publikation erhält, wird deutlich

vielfältiger abgebildet. - Beurteilung konkret für Artikel, nicht nach Quelle, in der er

veröffentlicht wurde - Open Access-Publikationen werden berücksichtigt.

- Ausdehnung auf weitere Veröffentlichungsformen neben Zeitschriftenartikeln

- Erwähnung in Netzwerken schneller als bei klassischen Veröffentlichungsformen/ Zitationen

- Transparenz: meist aus offenen Quellen über offene Schnittstellen

- nicht beschränkt auf wissenschaftliche Reaktionen (Nachteil?)

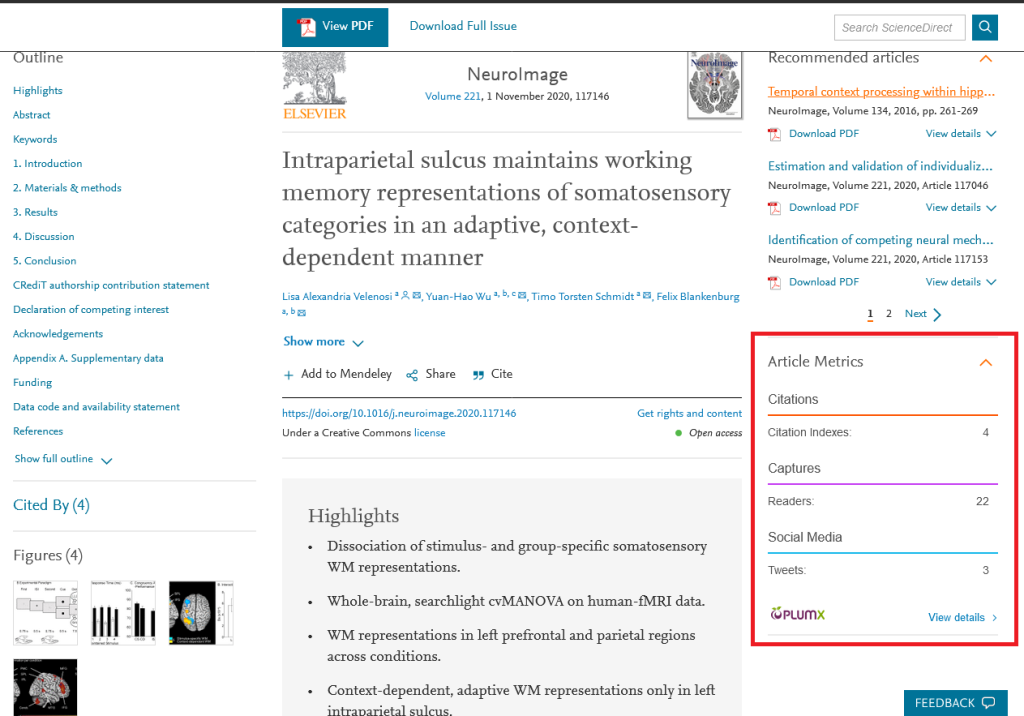

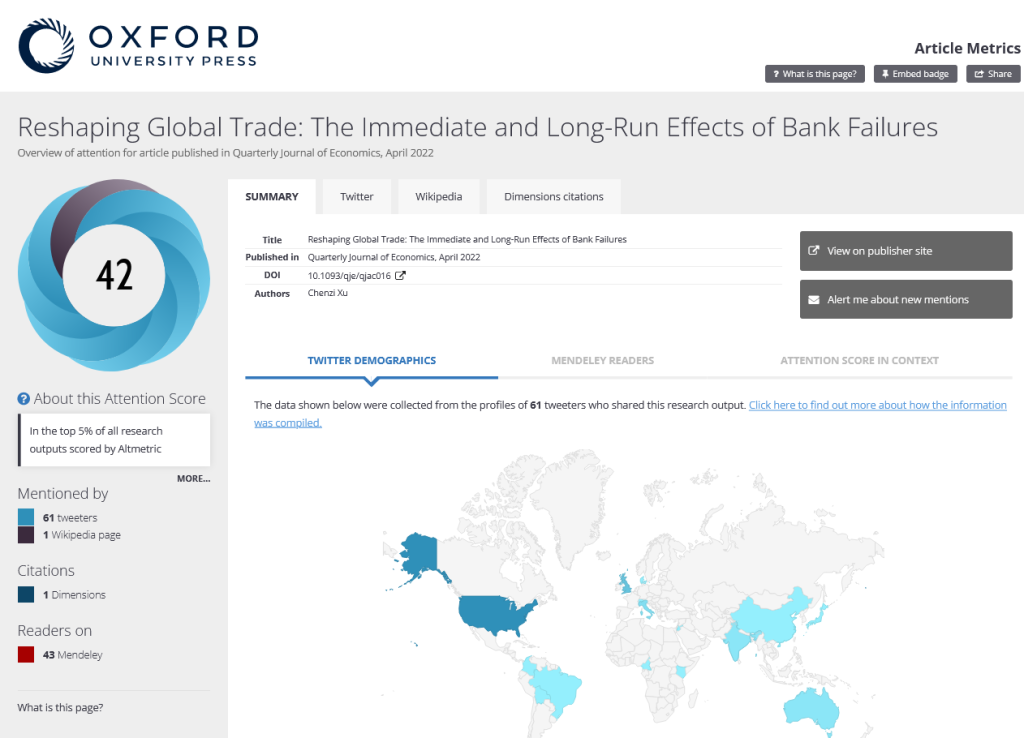

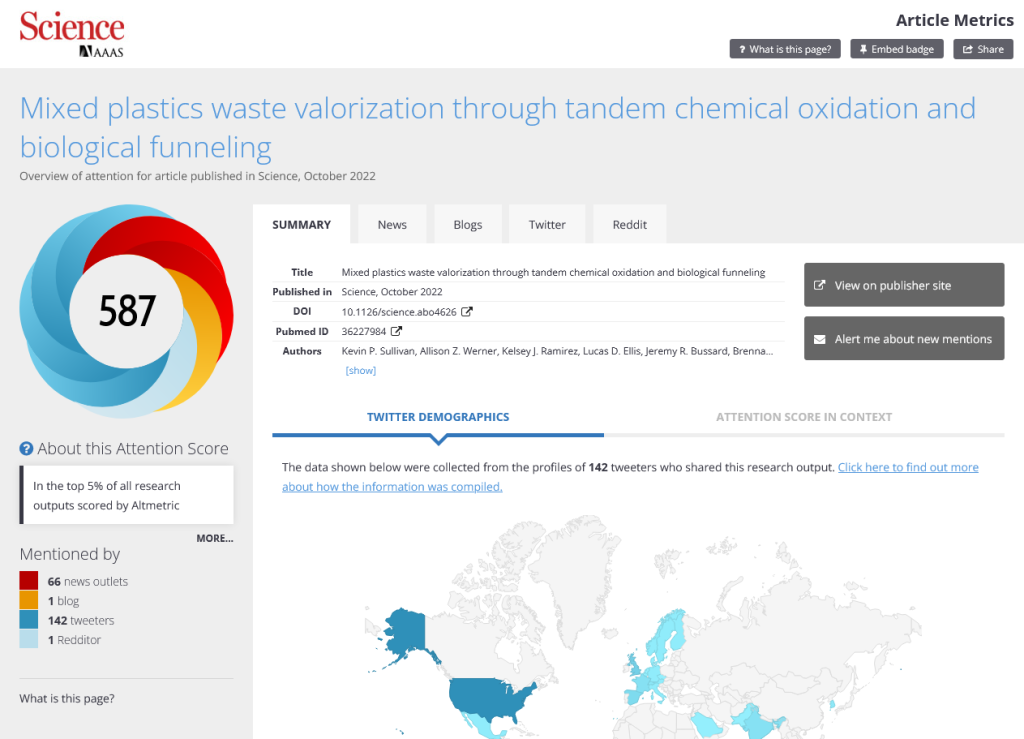

- Einbinden auf Verlagsseiten, universitären Repositorien usw. möglich

Schwächen der Methoden:

- Qualität der Auseinandersetzung mit der Publikation kann nicht

beurteilt werden. - Zahlen können leicht manipuliert werden.

- Populäre Autoren und Themen finden im Internet besonders viel Beachtung.

- nicht beschränkt auf wissenschaftliche Reaktionen

- einige Portale nicht berücksichtigt, da keine offenen Schnittstellen

z.Zt. Research Gate, academia.edu - Hintergrundwissen wie bei allen Methoden erforderlich, z. B.: Werden Tweets von Bots bereinigt? Werden Tweets und Retweets ohne Unterscheidung gezählt?

Weiterlesen:

Research Guide Altmetrics der Library der University of Waterloo: https://subjectguides.uwaterloo.ca/altmetrics

Der Artikel Ortega, J.L. Reliability and accuracy of altmetric providers: a comparison among Altmetric.com, PlumX and Crossref Event Data. Scientometrics 116, S. 2123–2138 (2018). https://doi.org/10.1007/s11192-018-2838-z vergleicht die drei Dienstanbieter, die wir hier als Beispiele für alternative Metriken heranziehen.